Искусственный интеллект все глубже входит в повседневную жизнь и рабочие процессы. И неудивительно, что злоумышленники не оставляют без внимания ИИ-системы, изыскивая способы их "ломки" и переподчинения.

Против лазера нет приема

Перефразируя известное утверждение, можно сказать, что если один человек что-то создал, другой обязательно постарается испортить. Как только искусственный интеллект вышел за пределы лабораторий и стал применяться на практике, как его немедленно начали пытаться "сломать" или заставить действовать в интересах злоумышленника. Средства обмана ИИ можно разделить на две главные категории "аппаратные" - когда для обмана ИИ используются физическими устройствами (иногда в сочетании с программными) и собственно программные.

Физические средства, как правило, проще…. И в тех случаях, когда они применимы, надежнее. Скажем, никакая, сколь угодно "умная" система распознавания лиц не устоит против компактных лазеров, которыми демонстранты в Гонконге засвечивали камеры видеонаблюдения. Надо отметить, что идея не нова - в советское время подобные стационарные системы были созданы для выжигания оптики на спутниках-шпионах, пресловутая "консьюмеризациия высоких технологий" добралась и до этой области. Остаться невидимым для систем распознавания лиц можно также с помощью специальной бликующей одежды или масок.

К "аппаратным" решениям относятся также системы искажения речи, не позволяющие идентифицировать говорящего, средства трехмерного сканирования и печати, с помощью которых можно обмануть системы идентификации по голове, лицу или отпечаткам (в том числе с нагревательными элементами для биометрических систем, в которых контролируется температура тела).

Машины против машин

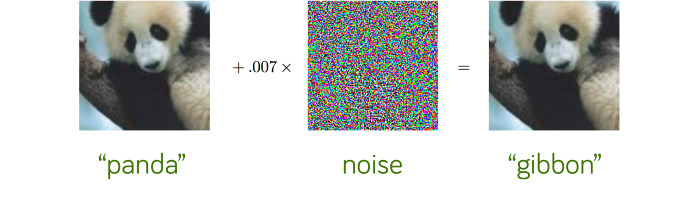

Программные средства обмана ИИ-систем также весьма многообразны. Поскольку искусственный интеллект в процессе "тренировки" нейросети учится не "пониманию" происходящего, а выдаче правильных ответов, то самоочевидна идея "неправильного обучения". В датасет "подмешиваются" неправильные данные, например - изображения. И "на выходе" еще недавно правильно работавший механизм распознавания начинает считать панду гиббоном.

Такую подмену, разумеется, трудно реализовать посторонним. Зато если она осуществлена, то такую закладку крайне трудно выявить. Во-первых, принимаемые нейросетевой системой решения в настоящее время невозможно проверить (методы такой проверки только разрабатываются), а, во-вторых, поскольку в более-менее сложной ИИ-модели тысячи параметров, провести ее исчерпывающее тестирование невозможно. Теоретически возможна ситуация, когда ИИ-система будет работать правильно во всех случаях, кроме тех когда получит ключевой сигнал, реакция на который когда-то была заложена злоумышленниками.

Впрочем, научиться обманывать конкретную ИИ-систему можно и удаленно - особенно, если известны алгоритмы ее обучения (алгоритмы как таковые секретом, как правило, не являются). Или, хотя бы "входные" наборы данных и принимаемые на их основе решения. В таком случае можно создать аналогичную модель и поэкспериментировать в поисках ее слабого места. И к поиску "пробивных" дата-сетов привлечь, опять же, ИИ-систему. Такое тестирование, разумеется, часто выполняют и сами владельцы ИИ-решений, пресловутая борьба щита и меча переходит на новый уровень.

От теории к практике

Наиболее наглядно встает проблема "взлома" ИИ, разумеется, в тех областях, где искусственный интеллект применяют или готовятся широко применять.

Так, системы ИИ тесно связаны с навигационными системами, которыми пользуются большинство автомобилистов. При этом сигналы такой системы можно либо заглушить и тогда автомобиль становится "невидимым" для трекера (устройства, отслеживающего перемещение объекта), либо создать много ложных сигналов от смартфонов и тем самым повлиять на поведение навигационного оборудования. Например, оно будет показывать затор на трассе, которого в реальности там нет. Последнего эффекта, не так давно удалось достичь берлинскому художнику просто медленно провезя тележку со смартфонами через мост.

Датчики беспилотного автомобиля можно запутать, нанеся на асфальт дополнительную разметку или добавив незначительные изменения на дорожные знаки. Человек без труда читает эти знаки правильно, а вот машина, ведомая искусственным интеллектом, почему-то начинает воспринимать как принципиально другие указатели. Самый известный пример знак "Стоп" при незначительных, с точки зрения человека, изменениях начинает восприниматься как знак ограничения скорости в 45 миль.

Вторая область, в которой ИИ используется обеими сторонами - кибербезопасность. ИБ-компании пытаются приспособить нейросети для обнаружения атак на компьютерные системы, злоумышленники, соответственно, осуществляют атаки с помощью ИИ. Интернет представляет собой отличную среду для тренировки злонамеренного искусственного интеллекта, так что важность "состязательного машинного обучения" (Adversarial ML) в ближайшие годы будет стремительно расти, а обеспечение безопасности ИИ-решений должна будет стать неотъемлемой частью курсов по информационной безопасности.